この記事では、同社CTOの吉田拓真氏が本AIを開発するに至った経緯などをメールインタビュー。本当に負けることが難しいのかも含め、ご紹介します。

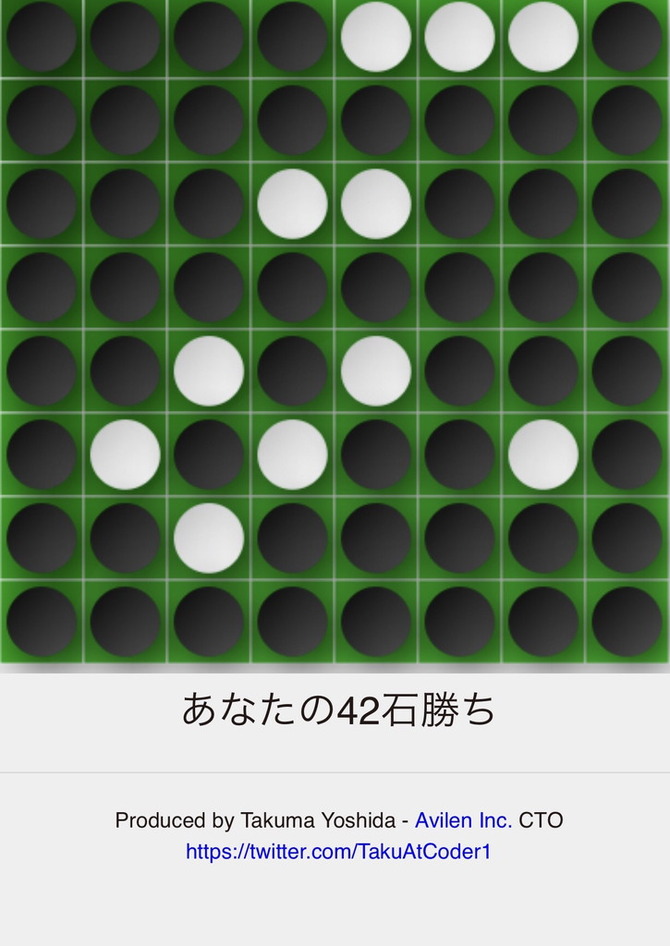

Web上で公開されている「最弱オセロ」は、スマホだけでなくPCでも遊べるオセロゲーム。記事執筆時点のAI戦績は、21勝5609敗6引分ということでハンパない負けっぷりです。では、このAI本当に弱いのでしょうか。自他共に認めるボードゲーム下手の筆者がさっそく挑んでみます。まずは普通に負けたら恥ずかしいので、真面目にやってみました。

このあと数回挑んでみたのですが、やはり勝ってしまう……。というかどうやっても角を4つ取ってしまう……。というわけではこの戦績に偽り無しのようです。

「AI」というワードからは連想しづらい「最弱」ですが、では、なぜこの「AI」が生まれたのでしょうか。前述の吉田氏にメールで話を伺ってみました。

――開発の経緯を教えてください。

吉田拓真氏(以下、吉田氏):このオセロAIは2016年私が東大工学部の学生のときに個人で開発しました。当時のAlphaGoの影響で、興味本位・勉強も兼ねて始めたのです。研究のあいまを使ってAlphaGoの論文含め、多くの資料を参考に深層学習とC++の勉強を一からやりましたね。ライブラリを使わずC++スクラッチで深層強化学習を実装し、それを日本発祥の好きなオセロに応用したのでした。開発自体は5ヶ月ほどで完成して放置しましたが、だれでも楽めるように、AVILENのメンバーの手も借りてwebに公開したところです。

――なぜ「最弱」なのでしょうか

吉田氏:最初は強さを求めて作っていましたし、こちらでは強いAIと対戦できます。もちろん、強いAIは他にもたくさんあるのですが、ちょうどそのときにYouTubeで負けに来るオセロの動画を見ました。それは相手が最善を打つ前提で、評価の悪い手を選んでるだけなので、あまり弱くなく、ランダムに勝ってりもしてます。そこで、私のコードは1行変えれば、とことん弱いAIを学習できることに気づきました。

深層強化学習AIの他の手法にないメリットは2点

1.人間が教えるわけではないので、どんなルールにも対応できる。

2.自己対戦で学習するので、棋譜がいらない(人間の手を全く学習しない)

やってみたところ、絶対に相手に勝たせるAIができたのですね。オセロというゲームが、「少なく取る」で成立するのも成功した一因です。とても面白いのは、真逆のはずのゲームですが、負けオセロの序盤の動きは勝ちオセロそのものです。だんだんありえない動きをしていきますが、オセロというゲームのさらに深い一面を見られたような気がします。

――何回か勝利してしまっていますが、これは予想の範囲内なんでしょうか

吉田氏:正直多少驚いています。Twitterなどで調べると、本当に強い有段者がかれこれ工夫して、まれに負けて(勝って)いるみたいです。人間はすごいですね。ただ、いくつかこちらの「手抜き」もあるので、ありえないことではないと思っています。

・本来12手探索できるところをサーバー負荷や、ユーザー体験のため、6手探索と半分に設定しています。(AIの計算は0.1秒)

・ユーザー体験のためランダム性をもたせています。必ず最善を打つわけではありません。

・強さを比べる対象がないので、あまり検証をせずに学習を止めています。

ということで、非常に面白いお話を聞くことができました。相当に頭を凝らせば負けることもできるそうなので、興味のある方はチャレンジしてもよいかもしれませんね。

なお、吉田氏は、7月27日(土)に行われる機械学習(AI・人工知能)に関するカジュアルトークイベント「第38回 Machine Learning 15minutes!」に登壇する予定。ここでオセロの話も少しするということです(記事執筆時点で定員50名のうち40名が埋まっています)。